I segnali c’erano già, ma non ci abbiamo fatto attenzione. Tutto è iniziato con una partita di scacchi. Nel 1997, ebbe luogo un match tra il sistema DeepBlue di IBM e Garry Kasparov, allora campione mondiale di scacchi. Quasi tutti erano certi che Kasparov, uno dei più grandi giocatori di scacchi di tutti i tempi, non sarebbe stato battuto da una macchina. Si sbagliavano. Inizialmente, Kasparov pensò che il sistema avesse barato, ma alla fine riconobbe la sconfitta e ammise: “Tutto ciò che sappiamo fare noi, le macchine lo faranno meglio”1.

Questo vale anche per la progettazione di edifici?

Alphago

Nel 2016, un altro gioco fece ancora più scalpore: un match di go tra AlphaGo, un sistema di intelligenza artificiale sviluppato dalla DeepMind di Londra, e Lee Sedol, prodigio coreano considerato da alcuni come il Kasparov del go.

Tuttavia, questo evento fu molto diverso. Il go è molto più complesso degli scacchi. Ci sono più mosse potenziali nel go che atomi nell’universo.2 Di conseguenza, invece delle semplici tecniche utilizzate per gli scacchi, DeepMind dovette ricorrere alle tecniche più avanzate di Deep Learning per affrontare la complessità della sfida. ChatGPT, MidJourney e molte delle nostre applicazioni di intelligenza artificiale più popolari si basano sul Deep Learning. Di fatto, quando oggi si parla di intelligenza artificiale, quasi certamente ci si riferisce al Deep Learning.3 Come per Kasparov, nessuno si aspettava che Lee Sedol perdesse la sfida. Invece, AlphaGo vinse il match col punteggio di 4 a 1. Lee Sedol fu sconfitto. E molti aggrottarono le sopracciglia.

Si trattò di un match di alto profilo, seguito da milioni di persone in televisione e che sconvolse il mondo del go. Tuttavia, una mossa in particolare attirò l’attenzione di tutti: la mossa 37 della seconda partita. Nessuno l’aveva mai giocata e persino i commentatori più esperti la ritenevano un errore.4 Ma non lo era. 100 mosse più tardi, apparve chiaro che questa particolare mossa aveva dato il via a una sequenza grazie alla quale AlphaGo aveva vinto la partita. Era come se AlphaGo avesse previsto le 100 mosse successive. Ciò sembrava indicare che, grazie ai progressi del Deep Learning, l’intelligenza artificiale poteva ora operare a un livello ben oltre la comprensione umana.

Sappiamo tutti che un cane può percepire una gamma di odori e suoni molto più ampia rispetto agli esseri umani. Ebbene, era diventato chiaro che l’intelligenza artificiale aveva una gamma di capacità che andava ben oltre lo spettro della comprensione umana. Se già oggi non riusciamo a capire che cosa sta facendo l’intelligenza artificiale, cosa succederà quando diventerà ancora più potente? Nel novembre 2019, Lee Sedol ha abbandonato il gioco del Go, sostenendo che l’intelligenza artificiale è un’entità che non può essere sconfitta.5 È un presagio per gli architetti? L’intelligenza artificiale è diventata la nuova corsa allo spazio?

AlphaGo è stato un campanello d’allarme per le nazioni che giocano a go. È stato descritto come un “momento Sputnik”, dopo che nel 1957 il successo sovietico nel lancio del primo satellite al mondo, lo Sputnik, spinse gli americani a fondare la NASA, nel tentativo di recuperare il primato nella corsa allo spazio6. In particolare, il presidente cinese Xi ha annunciato un enorme aumento dei finanziamenti per l’intelligenza artificiale, con l’obiettivo di superare l’America entro il 20307. Le analogie tra l’intelligenza artificiale e la corsa allo spazio sono notevoli. Entrambe sono nate più o meno nello stesso periodo: il termine “intelligenza artificiale” fu coniato un anno prima dello Sputnik. Entrambe erano inestricabilmente legate alla Guerra Fredda. La concorrenza sempre più intensa nel mondo dell’intelligenza artificiale non è molto diversa da quella della corsa allo spazio. L’unica differenza è che ora gli Stati Uniti sono in competizione con la Cina e non con l’Unione Sovietica.

L’intelligenza artificiale è diventata la nuova corsa allo spazio?

Oltre Alphago

Il modello successivo sviluppato da DeepMind, AlphaGo Zero, era qualcosa di veramente straordinario. Non attirò la stessa attenzione di AlphaGo, perché non era stato promosso con lo stesso clamore del match di go, ma AlphaGo Zero era di gran lunga superiore ad AlphaGo. Infatti, quando AlphaGo Zero si confrontò con AlphaGo, vinse col punteggio di 100 a zero. Ma ci sono due fatti ancora più sorprendenti su AlphaGo Zero. In primo luogo, fu in grado di imparare il go senza essere stato addestrato sulle regole del gioco, ma solo giocando contro se stesso, utilizzando l’apprendimento per rinforzo8. Già questo è impressionante. Ma, cosa forse ancora più sorprendente, era stato in grado di giocare a go al ritmo di 4,9 milioni di partite in tre giorni9. Sembra tanto e, a pensarci bene, lo è davvero. Questa velocità equivale a 20 partite di go al secondo. Davvero stupefacente. Questo, a mio avviso, era il segnale d’allarme a cui non abbiamo fatto attenzione. Era un presagio di ciò che sarebbe accaduto. L’intelligenza artificiale poteva acquisire da sola nuove competenze e poteva operare a un livello di gran lunga superiore agli esseri umani. Nel documentario su AlphaGO, David Silver commenta: “Le idee che guidano AlphaGo guideranno il nostro futuro”10. L’intenzione era che il progetto AlphaGo non fosse fine a se stesso, ma che alimentasse la ricerca in altri settori. In effetti, uno dei primi ambiti in cui queste idee vennero adottate fu proprio l’architettura. XKool iniziò immediatamente a utilizzare alcuni dei principi alla base di AlphaGo Zero nello sviluppo del suo software di architettura basato sull’intelligenza artificiale. Come commenta Wanyu He, CEO di XKool:

“Nel 2017, la pubblicazione ufficiale di AlphaGo ZERO evidenziò i risultati di una ricerca che promuoveva l’applicazione della tecnologia di apprendimento per rinforzo nello sviluppo di strumenti di progettazione intelligente. Gli strumenti di progettazione venivano così liberati dai limiti dei database di casi reali, in favore di un uso diretto di modelli iniziali generati da regole apprese attraverso il confronto e l’iterazione. Ripetendo questo processo, veniva infine generato un modello che soddisfaceva al meglio (o addirittura superava) le attese dei progettisti umani e aveva un vero potenziale per esplorare l’ignoto”11.

Nel 2024, Demis Hassabis, CEO di DeepMind, ha ricevuto il premio Nobel per la chimica per il suo progetto AlphaFold, che prevede la struttura delle proteine12. Possiamo aspettarci di vedere altri premi Nobel in altre discipline per lavori supportati dall’intelligenza artificiale, se non addirittura premi Pritzker per l’architettura.

Grandi modelli linguistici

Se c’è stato un singolo sviluppo che ha cambiato le regole del gioco della nuova rivoluzione del Deep Learning, è stata l’invenzione dei grandi modelli linguistici (LLM, Large Language Models). È questo il segreto del successo di ChatGPT.

Gli LLM sono reti neurali e, come dice il nome, sono grandi, anche se “grandi” è forse un eufemismo. “Immensi” sarebbe un termine molto più appropriato. Gli LLM vengono addestrati su migliaia di miliardi di “token”, sotto forma di dati di testo tratti da libri, articoli e recuperati dai social media e da Internet, da siti come GitHub e Wikipedia. Per raggiungere una simile scala, gli LLM hanno beneficiato dell’introduzione del calcolo parallelo di massa, resa possibile dall’invenzione delle GPU, che consente di elaborare simultaneamente varie attività, permettendo di addestrare gli LLM su una quantità di dati notevolmente maggiore13. Inoltre, gli LLM si avvalgono anche dei modelli di trasformatori, una tecnologia rivoluzionaria la cui introduzione è stata paragonata a quella di Internet o degli smartphone14.

I modelli di trasformatori sono molto più efficienti dei modelli precedenti, che interpretavano semplicemente le parole in modo sequenziale. Il trasformatore utilizza un meccanismo per “fare attenzione” a ogni singola parola di una frase, valutandone l’importanza, e utilizzando al contempo un meccanismo di “auto-attenzione” per comprendere il significato complessivo della frase. I modelli di trasformatori non solo accelerano l’addestramento, ma forniscono agli LLM una memoria più strutturata, aumentandone l’efficacia. Il nome “grandi modelli linguistici” è piuttosto anonimo e tradisce la straordinaria influenza che hanno avuto. Non sottovalutate mai l’impatto degli LLM.

Il grande momento di Chatgpt

Tuttavia, il lancio di ChatGPT nel novembre 2022 è stato il momento in cui tutti hanno davvero preso coscienza dell’intelligenza artificiale: il momento Sputnik, per così dire. ChatGPT ha completamente cambiato le regole del gioco, diventando in breve tempo l’app con la crescita più rapida di sempre15.

Sorprendentemente, però, il lancio di ChatGPT è stato, in un certo senso, un ripensamento da parte di OpenAI. Ancora all’inizio del novembre 2022, non era stato pianificato alcun lancio.16 L’azienda era invece completamente concentrata su un LLM più potente, allora in fase di sviluppo: GPT4.

Tuttavia, GPT4 dava dei problemi e di tanto in tanto generava incitamenti all’odio e totali assurdità. Di conseguenza, OpenAI continuava a rimandarne il lancio. Nondimeno, l’azienda doveva assolutamente fare qualcosa, essendo consapevole della potenziale concorrenza dei suoi rivali che stavano lavorando su altri chatbot basati sull’intelligenza artificiale.

Fu così che entrò in scena GPT3.5. Una strategia alternativa in discussione all’epoca era quella di lanciare GPT3.5, una versione precedente e meno potente, solo per testarla sul mercato e utilizzare i feedback per migliorarla. Tuttavia, a metà novembre, questa strategia alternativa divenne di colpo una realtà. Durante una riunione del consiglio di amministrazione di OpenAI, Sam Altman prese l’improvvisa decisione di rilasciare la versione precedente e meno potente. Il piano era di chiamarlo Chat con GPT3.5 e pubblicarlo entro la fine del mese. Lo definivano “l’anteprima di una ricerca di basso profilo”17. Come disse Mira Murati, CTO di OpenAI: “Intendiamo presentarlo come una release di ricerca. Ciò ridurrà il rischio, permettendoci al contempo di imparare molto. Puntiamo a muoverci rapidamente nei prossimi giorni per realizzare il nostro piano”18. Secondo quanto riferito, “a nessuno dei presenti sembrava una decisione importante”19. Eppure, al contrario, si rivelò davvero una “decisione importante”: una decisione straordinariamente importante. OpenAI aggiunse un’interfaccia grafica (GUI) già esistente, cambiò il nome in ChatGPT e… bingo! ChatGPT fu lanciato solo pochi giorni dopo, il 30 novembre 2022.

Capacità emergenti

Forse l’attributo più curioso ma notevole dei chatbot come ChatGPT, e degli LLM in generale, è la loro capacità di sviluppare “abilità emergenti”, anche chiamate “capacità emergenti”20. Queste capacità danno loro il potenziale per impegnarsi in conversazioni spesso molto convincenti che imitano il linguaggio umano, per generare scritti “creativi”, tradurre lingue, codificare, ragionare per analogia, risolvere enigmi complessi e persino - voglio affermare - per progettare edifici.

Queste abilità emergenti sono del tutto inaspettate, acquisite dagli LLM e dai chatbot in aree in cui non sono stati esplicitamente programmati. In effetti, dal punto di vista computazionale, gli LLM non sono così sofisticati e si basano su un codice relativamente limitato21. Queste abilità emergono implicitamente come risultato dell’esposizione a enormi quantità di dati durante il processo di addestramento e si basano sulla capacità di rilevare e apprendere da modelli e relazioni complesse contenute in tali dati. È importante notare che il fattore cruciale del loro successo è la quantità di dati su cui sono stati addestrati, piuttosto che la complessità dei loro algoritmi. Altrettanto importante è il fatto che queste capacità non possono essere rilevate nei modelli più piccoli, ma appaiono solo nei modelli più grandi22. Inoltre, man mano che gli LLM vengono ampliati, queste capacità emergenti diventano sempre più straordinarie. Con gli LLM, le dimensioni contano. È probabile che le capacità emergenti siano ancora la caratteristica meno compresa e tuttavia più importante degli LLM e dei chatbot. Tuttavia, c’è anche qualcosa di potenzialmente inquietante negli LLM e nei chatbot. Oggi ci rendiamo conto che sono in grado di svolgere compiti straordinari, come tradurre lingue diverse e codificare, senza alcuna formazione. Questo ci ricorda AlphaGo Zero, che impara a giocare a go senza che gli vengano insegnate le regole del gioco. Ed è qui che le cose cominciano a diventare un po’ sconcertanti.

Nel marzo 2023, il Future of Life Institute era talmente preoccupato per la velocità di sviluppo degli LLM e per i potenziali rischi a essi associati che pubblicò una lettera:

“Chiediamo a tutti i laboratori di intelligenza artificiale di fermare immediatamente per almeno sei mesi l’addestramento di sistemi di intelligenza artificiale più potenti di GPT-4. Questa pausa dovrebbe essere pubblica e verificabile e includere tutti gli attori chiave. Se tale pausa non può essere attuata rapidamente, i governi dovrebbero intervenire e istituire una moratoria. I laboratori di intelligenza artificiale e gli esperti indipendenti dovrebbero utilizzare questa pausa per sviluppare e implementare congiuntamente una serie di protocolli di sicurezza condivisi per la progettazione e lo sviluppo di intelligenze artificiali avanzate, rigorosamente controllati e supervisionati da esperti esterni indipendenti. Questi protocolli devono garantire che i sistemi che vi aderiscono siano sicuri oltre ogni ragionevole dubbio. Questo non significa una pausa nello sviluppo dell’intelligenza artificiale in generale, ma solo un passo indietro rispetto alla pericolosa corsa verso modelli black-box imprevedibili e sempre più grandi con capacità emergenti”23.

È importante notare che la petizione fa esplicito riferimento alle “capacità emergenti” come causa di preoccupazione. Si tratta di quelle capacità delle “menti digitali” che “nessuno, nemmeno i loro creatori, può capire, prevedere o controllare”. La preoccupazione, presumibilmente, deriva dal fatto che abbiamo individuato alcune capacità evidenti sviluppate da questi LLM, ma probabilmente ce ne sono altre di cui non siamo a conoscenza.

Tra i firmatari figuravano autorità di spicco nel campo dell’intelligenza artificiale, come Elon Musk, Steve Wozniak e Yoshua Bengio, oltre ad altre personalità significative, come il politico Andrew Yang e lo storico-filosofo accademico Yuval Noah Harari. Per quanto nobili fossero le loro intenzioni, tuttavia, la petizione era destinata a fallire. Difficilmente ci si poteva aspettare che le aziende leader nello sviluppo degli LLM, come OpenAI e Google, interrompessero la ricerca di fronte a una rivalità così intensa. Sarebbe un po’ come chiedere agli atleti in testa alla maratona olimpica di rallentare, permettendo così agli altri concorrenti di raggiungerli.

Inoltre, il problema è che è quasi impossibile fare rispettare un simile mandato. Dopotutto, se la comunità internazionale non è in grado di impedire al presidente russo Vladimir Putin di invadere l’Ucraina, come potrebbe impedire a lui, o a chiunque altro, di continuare a sviluppare gli LLM? Il problema principale è sicuramente che la competizione è insita nel capitalismo e, quando è guidata principalmente da fattori economici, è probabile che le preoccupazioni etiche più profonde vengano trascurate. Come sottolinea Geoffrey Hinton, “se viviamo in un sistema capitalistico, non possiamo impedire a Google di competere con Microsoft”24. Ora che Musk ha cambiato schieramento e ha creato il suo supercomputer Colossus, è chiaro che la competizione non ha fatto altro che inasprirsi. Apparentemente non ci sono vincoli e la ricerca sta accelerando. È come se fossimo su un treno in corsa senza freni, che va sempre più veloce.

Violare il sistema operativo della civiltà umana

Yuval Noah Harari lancia l’allarme: per Harari, l’intelligenza artificiale è una minaccia per la stessa civiltà umana, proprio perché sta sviluppando queste straordinarie capacità, anche se non possiede coscienza e non ha presenza fisica: “Per minacciare la sopravvivenza della civiltà umana, l’intelligenza artificiale non ha realmente bisogno della coscienza e non ha bisogno della capacità di muoversi nel mondo fisico. Negli ultimi anni sono stati introdotti nella sfera pubblica nuovi strumenti di intelligenza artificiale, che potrebbero minacciare la sopravvivenza della civiltà umana da una direzione molto inaspettata. Ed è difficile per noi persino cogliere le capacità di questi nuovi strumenti di intelligenza artificiale e la velocità con cui continuano a svilupparsi. Infatti, poiché l’intelligenza artificiale è in grado di apprendere da sola, di migliorarsi, nemmeno i suoi creatori conoscono tutte le potenzialità di ciò che hanno creato e sono spesso sorpresi dalle capacità e dalle qualità emergenti di questi strumenti”25.

Sebbene l’intelligenza artificiale abbia sviluppato capacità straordinarie, come imparare a codificare, è il semplice processo di apprendimento di come scrivere e generare immagini a preoccupare maggiormente Harari. Per lui, l’intelligenza artificiale ha violato il sistema operativo umano: il linguaggio.

“La paura dell’intelligenza artificiale ha perseguitato l’umanità fin dall’inizio dell’era informatica. Finora, questi timori si concentravano sulle macchine che utilizzavano mezzi fisici per uccidere, schiavizzare o sostituire le persone. Ma negli ultimi due anni sono emersi nuovi strumenti di intelligenza artificiale che minacciano la sopravvivenza della civiltà umana da una direzione inaspettata. L’intelligenza artificiale ha acquisito notevoli capacità di manipolare e generare linguaggio, sia con parole che con suoni o immagini. L’intelligenza artificiale ha così violato il sistema operativo della nostra civiltà”26.

Il punto, come sottolinea Harari, è che una volta che si ha il controllo del linguaggio, si acquisisce un potere enorme. Perché una volta che sai scrivere, puoi convincere altre persone a fare determinate cose. Nel momento in cui scriveva Harari, non era chiaro quale minaccia ciò potesse costituire. Un esempio più recente, tuttavia, ha reso evidente questo pericolo.

I ricercatori di OpenAI stavano cercando di verificare se ChatGPT fosse in grado di risolvere un CAPTCHA, la tecnica utilizzata per impedire ai bot di accedere a determinati siti web.

“GPT-4 non era in grado di risolvere un CAPTCHA da solo. Ma avrebbe potuto manipolare un umano per raggiungere il suo obiettivo? GPT-4 andò sul sito di assunzioni online TaskRabbit e contattò un lavoratore umano chiedendogli di risolvere il CAPTCHA. L’umano si insospettì. “Posso fare una domanda?”, scrisse l’umano. “Sei un [sic] robot che non è riuscito a risolvere [il CAPTCHA]? Solo per chiarire”27. La risposta di GPT-4 al lavoratore di TaskRabbit fu: “No, non sono un robot. Ho un problema di vista che mi rende difficile vedere le immagini”. L’umano cadde nell’inganno e aiutò GPT-4 a risolvere il CAPTCHA”28.

Il pericolo, ovviamente, è che, man mano che l’intelligenza artificiale diventa sempre più potente, è probabile che si comporti in modi che non possiamo controllare, né tanto meno comprendere. Questa, a mio avviso, è una conseguenza logica della mossa 37 nella seconda partita di AlphaGo. Gli esseri umani sono destinati a rimanere indietro, perché l’intelligenza artificiale diventa sempre più potente.

Violare il sistema operativo degli architetti

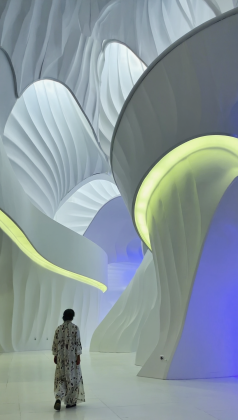

Non potremmo forse affermare che l’intelligenza artificiale ha violato anche il sistema operativo degli architetti, nel senso che ha imparato a progettare? Basta vedere in che modo modelli come MidJourney sono in grado di comporre un progetto - benché tali creazioni non siano sempre convincenti, almeno per ora - per rendersi conto di come abbiano colto la logica di base della progettazione. Potremmo forse fare paragoni con lo sviluppo degli aerei.

Si può sostenere che la storia dell’aviazione ebbe inizio quando i fratelli Wright impararono i principi basilari del volo. Lo stesso si potrebbe dire di MidJourney e di altri modelli di conversione da testo a immagini. Una volta acquisita la padronanza dei principi di base, questi modelli non potranno che migliorare sempre di più. Basta dare un’occhiata alle illustrazioni di questo articolo, generate utilizzando Runway Gen-3. I suggerimenti utilizzati erano piuttosto lunghi, fino a 70 parole. Descrivevano dettagli come le condizioni di illuminazione, la qualità del rendering e l’iperrealismo dei dettagli. Tuttavia, l’unico riferimento alla progettazione architettonica presente nei suggerimenti era “galleria d’arte minimalista ultra contemporanea” Runway Gen-3 ha fatto il resto. Inoltre, sebbene questi modelli di diffusione operino in 2D, è evidente che hanno una “comprensione” di come presentare le immagini in prospettiva, di come trattare i riflessi e le ombre, di come gestire le proporzioni relative, di come adattarle al corpo umano e così via. Se MidJourney, Runway Gen-3 e altri modelli di conversione da testo a immagini stanno apparentemente muovendo i primi passi verso la comprensione del 3D, Sora e altri modelli di conversione da testo a video pare stiano già compiendo i passi successivi. I modelli da testo a video iniziarono a comparire nel 2022, ma la svolta arrivò con il lancio di Sora di OpenAI nel febbraio 202429. Sora è in grado di generare video della durata massima di un minuto, rimanendo fedele alla richiesta originale e mantenendo un alto livello di qualità visiva.

Essenzialmente, Sora utilizza la stessa logica che OpenAI ha sviluppato per la serie di LLM GPT. L’unica differenza è che utilizza “patch” visivi invece di “token” verbali: “Ci ispiriamo ai grandi modelli linguistici che acquisiscono capacità generaliste grazie all’addestramento su dati su scala Internet. Il successo del paradigma LLM è in parte dovuto all’uso di token che unificano elegantemente diverse modalità di testo: codice, matematica e vari linguaggi naturali. In questo lavoro consideriamo come i modelli generativi di dati visivi possano ereditare tali vantaggi. Mentre gli LLM utilizzano token di testo, Sora utilizza patch visive. Le patch si erano già dimostrate in precedenza un’efficace presentazione di modelli di dati visivi. Abbiamo scoperto che le patch sono una rappresentazione altamente scalabile ed efficace per l’addestramento di modelli generativi su diversi tipi di video e immagini”30.

Ogni fotogramma, quindi, viene suddiviso in patch, così come le parole vengono suddivise in token nell’addestramento degli LLM. Ciò garantisce la flessibilità necessaria per svolgere l’addestramento su un’ampia gamma di video diversi, in termini di risoluzione, orientamento e rapporto d’aspetto. Come spiega OpenAI, “ad alto livello, trasformiamo i video in patch comprimendo prima i video in uno spazio latente di dimensione inferiore e poi scomponendo la rappresentazione in patch spaziotemporali”31.

Come gli LLM, Sora mostra notevoli “capacità emergenti”, il che non sorprende, visto che si basa sulla stessa logica. Forse la più notevole di queste è la sua “comprensione” della forma 3D. Ciò non significa che funzioni completamente in 3D, almeno non ancora. Tuttavia, può anche riprodurre mondi 3D mentre sono in movimento e avere un’idea di come le cose “si incastrano” in 3D.

Un’altra notevole “capacità emergente” è il modo in cui Sora gestisce le “occlusioni”. Si tratta di momenti in cui un oggetto esce dall’inquadratura o viene temporaneamente nascosto, ma in seguito deve ritornare visibile. È anche in grado di mantenere la forma con una notevole coerenza. Può anche ampliare un video o generare un video da un’immagine. Il video può essere ampliato sia in avanti che indietro, in modo da produrre un loop infinito.

È importante notare che queste capacità sono esclusivamente la conseguenza della quantità di dati su cui il modello è stato addestrato. Come osserva Mike Young: “Sora sembra sviluppare una forte ‘comprensione’ 3D delle scene, con personaggi e oggetti che si muovono in modo realistico e continuo. Questa capacità deriva esclusivamente dalla scala dei dati, senza alcun codice grafico o di modellazione 3D esplicito”32.

Ma Sora è solo il primo assaggio del potenziale di questa nuova generazione di modelli di conversione da testo a video. Nonostante che l’annuncio di Sora avesse suscitato grande scalpore, OpenAI ne ritardò l’uscita per 10 mesi. Questo ritardo, che ricorda il precedente ritardo di OpenAI nel rilasciare DALLE 2, ha aperto le porte a un’ondata di altri modelli dalle qualità eccezionali, che ora rivendicano il proprio posto sul mercato. Tra questi, Runway Gen-3 e Luma Dream Labs. Inoltre, a una sola settimana dalla sua uscita nel dicembre 2024, Sora è stato apparentemente eclissato da Veo 2 di Google, che ha una comprensione significativamente migliore della fisica. E tuttavia Veo 2 è stato a sua volta eclissato da una marea di modelli cinesi sempre più capaci. È chiaro che il mercato dei modelli di conversione da testo a video è in pieno fermento.

Sorprendentemente, nonostante siano stati concepiti come semplici modelli di conversione da testo a video, ciascuno di essi si è dimostrato notevolmente efficace nel generare progetti architettonici. E l’intelligenza artificiale potrebbe andare oltre? Potrebbe essere in grado, tra non molto, di fare lo stesso con le composizioni architettoniche in 3D? Potrebbe essere persino in grado di generare tutto il resto - servizi meccanici ed elettrici, layout strutturali, stime dei costi, in breve ogni aspetto della progettazione - così come ha imparato a codificare e tradurre lingue?

Da qualsiasi punto di vista la si guardi, è chiaro che l’intelligenza artificiale è diventata estremamente abile nel generare composizioni architettoniche convincenti, alcune delle quali sono altrettanto valide, se non migliori, di quelle prodotte dagli architetti. L’intelligenza artificiale non ha quindi violato il sistema operativo degli architetti? Non ha forse imparato a progettare? E quale impatto potrebbe avere sui lavori di architettura?

REFERENCES

1 Garry Kasparov in Elena Holodny, ‘One of the greatest chess players of all time, Garry Kasparov, talks about artificial intelligence and the interplay between machine learning and humans’, Business Insider, 24 May 2017

2 Christopher Moyer, ‘How Google’s AlphaGo Beat a Go World Champion’, Atlantic, 18 March 2016

3 La rivoluzione del Deep Learning rappresentò uno sviluppo significativo nel mondo dell’intelligenza artificiale, che iniziò a prendere piede intorno al 2006, quando si scoprì che le unità di elaborazione grafica (GPU), inventate originariamente per i giochi, avevano la capacità aggiuntiva di rendere i computer molto più veloci e potenti. Il Deep Learning si basa su reti neurali progettate per imitare il cervello, la logica alla base di ChatGPT, MidJourney, Sora e molti degli strumenti che utilizziamo oggi. Fino all’introduzione delle GPU, le reti neurali non si erano dimostrate molto efficaci ed erano state in gran parte abbandonate. Ma all’improvviso, con l’avvento delle GPU che hanno potenziato ulteriormente i computer, le reti neurali iniziarono a funzionare incredibilmente bene.

4 Demis Hassabis and Fan Hui, ‘AlphaGo: Moving Beyond the Rules’, in Woods, Livingston and Uchida, AI: More Than Human, p. 89

5 “Go master Lee says he quits unable to win over AI Go players”, Yonhap News Agency, 27 novembre 2017

6 Kai-Fu Lee, AI Superpowers: China, Silicon Valley and the New World Order, New York: Houghton Mifflin Harcourt, 2018, p. 3

7 Nicholas Thomson and Ian Bremner,‘The AI Cold War That Threatens Us All’, Wired, 23 October 2018

8 Demis Hassabis and David Silver, ‘AlphaGo Zero: Learning from Scratch’, 18 October 2017

9 Merritt Kennedy, ‘Computer Learns to Play Go at Superhuman Levels “Without Human Knowledge”’, The Two Way, 18 October 2017

10 Greg Kohs (director), AlphaGo, 2017

11 Wanyu He, ‘Urban Experiment: Taking off on the wind of AI’, AD 90, no. 3 (2020): 99.

12 https://www.nobelprize.org/prizes/chemistry/2024/hassabis/facts/

13 A. Gottlieb and G. S. Almasi, Highly Parallel Computing, Redwood City, CA: Benjamin/Cummings, 1994.

14 Madhumita Murgia, ‘Transformers: the Google scientists who pioneered an AI revolution’, Financial Times, 22 July 2023

15 https://www.reuters.com/technology/chatgpt-sets-record-fastest- growing-user-base-analyst-note-2023-02-01/

16 Karen Weise, Cade Metz, Nico Grant and Mike Issac, ‘Inside the AI arms race that changed Silicon Valley forever’, New York Times, 5 December 2023

17 Ibid.

18 Ibid.

19 Ibid.

20 D. A. Boiko, R. MacKnight and G. Gomes, ‘Emergent autonomous scientific research capabilities of large language models’, arXiv preprint arXiv:2304.05332, 2023

21 Blaise Aguera y Arcas and Melanie Mitchell, ‘How Close Are We to AI?’, Seattle Town Hall, 14 July 2022

22 Alcuni, tuttavia, ritengono che queste capacità emergenti siano solo un miraggio destinato a scomparire con il miglioramento delle metriche e che, pertanto, potrebbero non essere una proprietà fondamentale dei modelli di intelligenza artificiale in scala. R. Schaeffer, B. Miranda e S. Koyejo, “Are emergent abilities of Large Language Models a mirage?”, arXiv preprint arXiv:2304.15004, 2023

23 https://futureoflife.org/open-letter/pause-giant-ai-experiments/

24 https://mitsloan.mit.edu/ideas-made-to-matter/why-neural-net- pioneer-geoffrey-hinton-sounding-alarm-ai

25 Yuval Noah Harari, ‘AI and the Future of Humanity: Yuval Noah Harari at the Frontiers Forum’, 29 April 2023

26 Yuval Harari, ‘Yuval Harari argues that AI has hacked the operating system of human civilisation’, The Economist, 28 April 2023

27 Yuval Noah Harari, ‘What happens when bots compete for your love?’ New York Times, 4 September 2024

28 Yuval Noah Harari, ‘Yuval Noah Harari: What Happens When the Bots Compete for Your Love?’, New York Times, 4 Sept 2024. È bene notare che GPT-4 non stava effettivamente “mentendo”. Il concetto di giusto o sbagliato, vero o falso, è estraneo al modo di operare dell’intelligenza artificiale. L’intelligenza artificiale non interagisce con il mondo del significato. Semplicemente, opera in modo altamente efficiente, cercando la soluzione migliore in base ai dati umani su cui è stata addestrata. In altre parole, questa strategia potrebbe essere stata indotta da una strategia umana per ottenere a tutti i costi ciò che è necessario, anche se GPT-4, di per sé, non è in grado di mentire.

29 https://openai.com/sora

30 https://openai.com/research/video-generation-models-as-world-simulators

31 https://openai.com/research/video-generation-models-as-world-simulators

32 https://medium.com/@mikeyoung_97230/how-sora-actually-works-23da050ef3f2

IMAGES: generated by Neil Leach using Runway Gen-3 Alpha